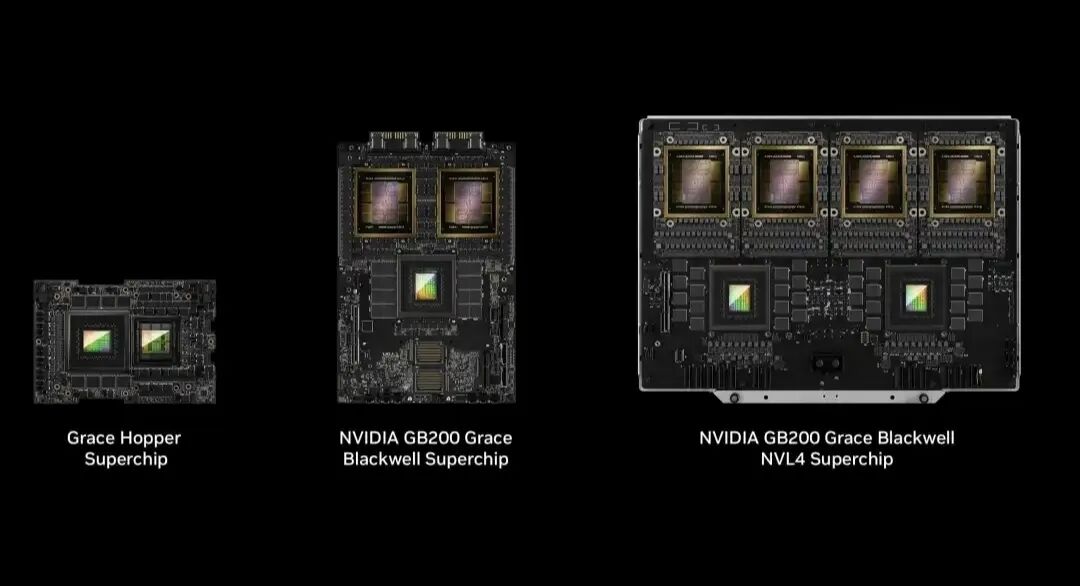

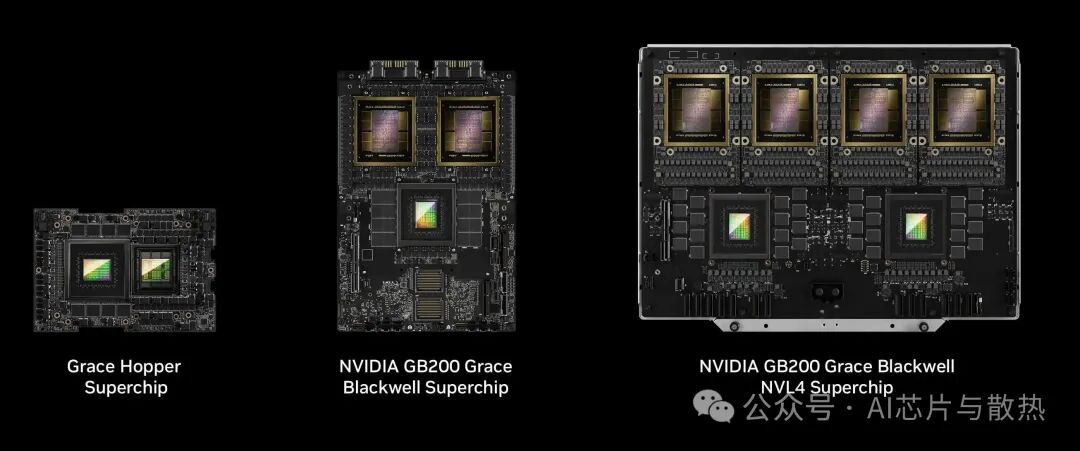

NVIDIA Blackwell 平台的问世,特别是 GB200 NVL72 机柜级系统,标志着一个行业拐点——直接芯片(Direct-to-Chip, DTC)液冷技术从高性能计算的利基解决方案,转变为生成式人工智能基础设施不可或缺的主流技术。这一转变的根本原因在于 Blackwell 架构带来了前所未有的热能挑战,单个机柜的功耗高达 120-140kW,远超传统风冷技术的物理极限。

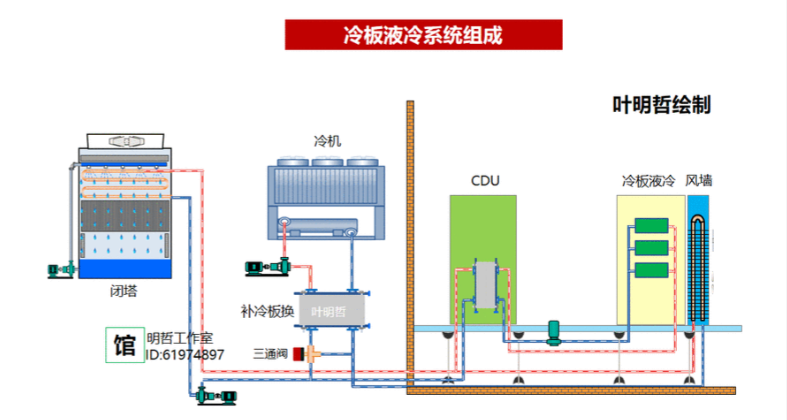

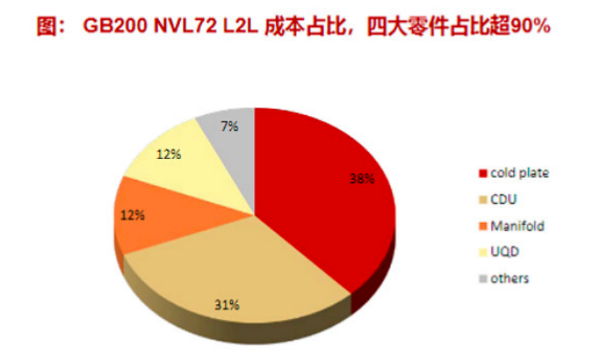

散热系统的关键在于四大硬件支柱:冷板、冷却液分配单元、歧管与管路以及快速断开接头。其中冷板凭借其在材料和微加工方面的要求,占据了约 40-45% 的成本份额,成为成本最高的组件。紧随其后的是作为系统“心脏”的 CDU,其成本占比约为 30-35%。

令人关注的是,尽管快速断开接头体积小,但因其高精度和大规模部署,其成本贡献达到了 15-20%,构成了一个关键的成本中心和潜在的供应链瓶颈。歧管与管路则占据剩余的 5-10%。

一、英伟达冷板式液冷拆解

1、关键四大零件

- Cold plate(液冷板)

- CDU(Coolant distribution unit,冷却液分配单元)

- Manifold(冷却水歧管)

- UQD(冷却液快接头)

2、液冷系统组成及成本拆解

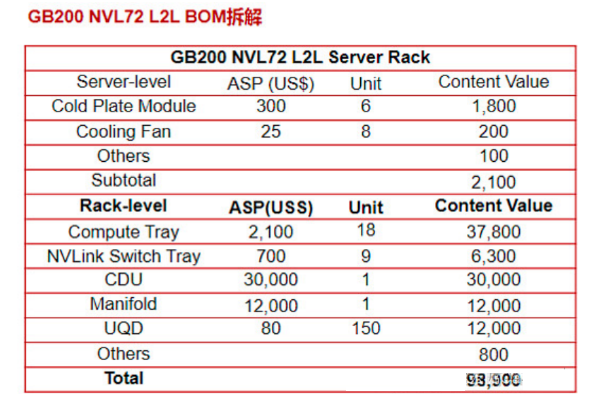

1. GB200散热系统成本

液冷系统组成及成本拆解

- 主要组件成本占比:

- 冷板:约 40%-45%,是成本最高的组件,因需使用高纯度铜材及精密微加工工艺。

- 冷却液分配单元:约 30%-35%,包含工业级泵、热交换器等复杂部件。

- 快速断开接头:约 15%-20%,虽体积小但单价高、使用数量多。

- 歧管与管路:约 5%-10%,成本相对较低。

- 单机柜总成本:约 10 万美元,其中四大组件(冷板、CDU、UQD、歧管)占总成本 90% 以上。

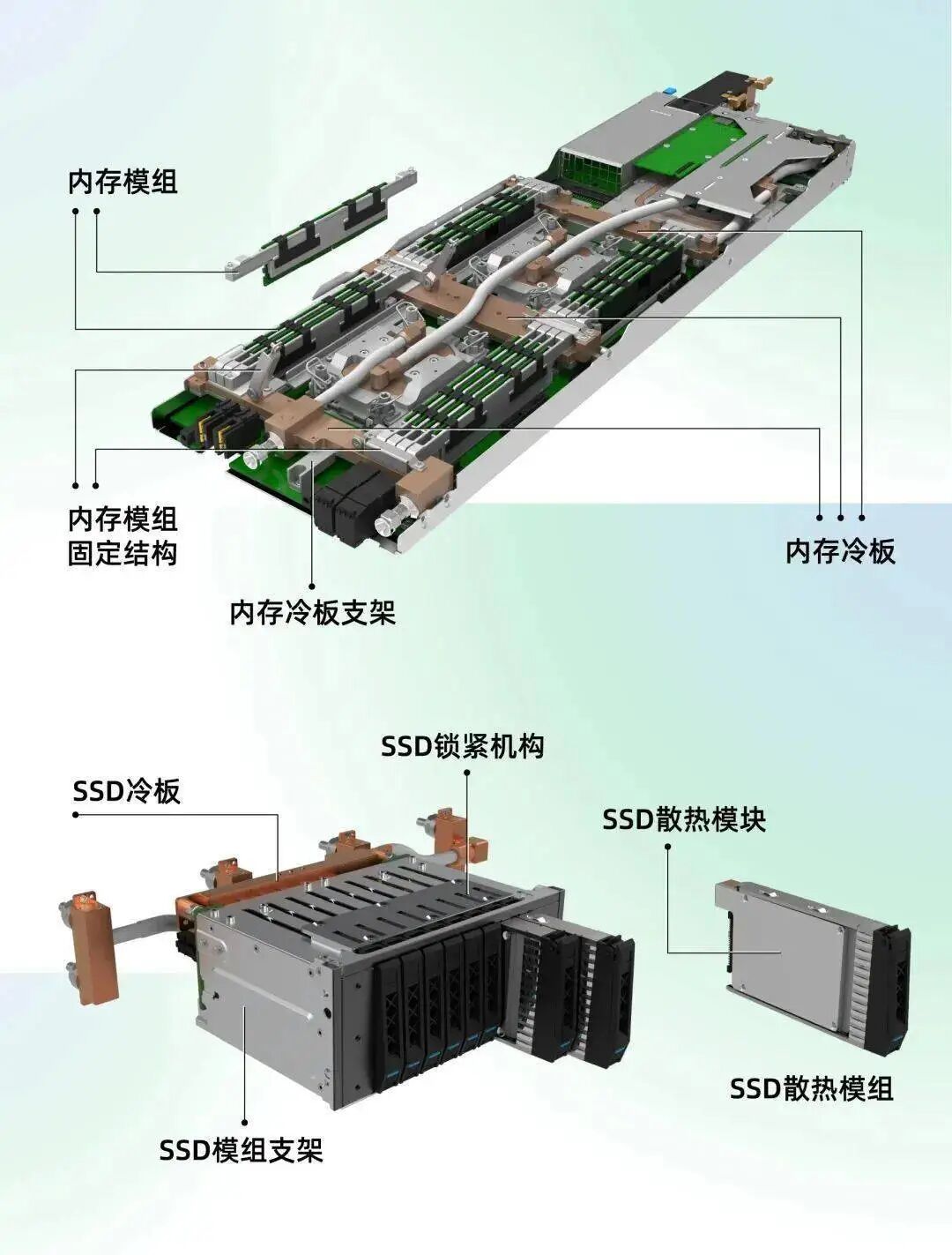

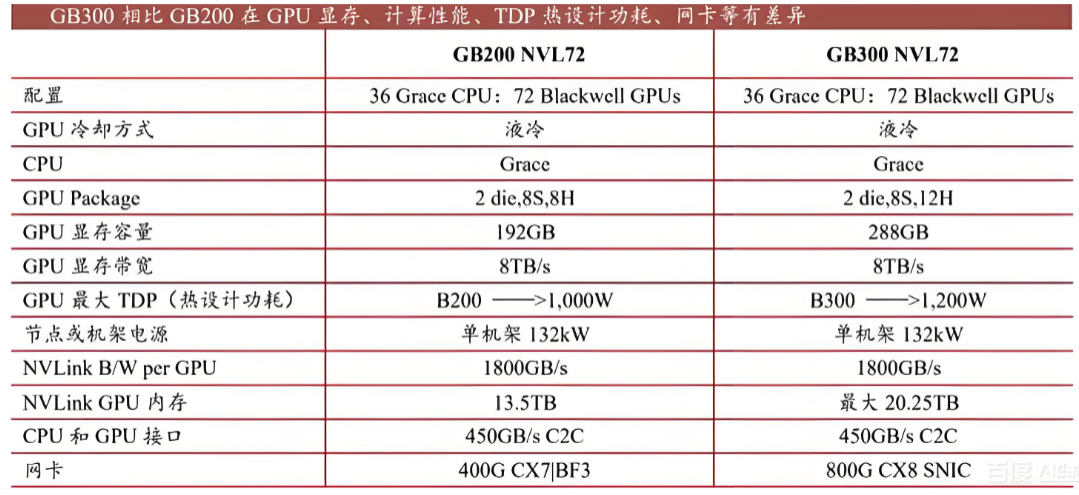

2. GB300散热系统成本

- 关键改进与成本变化:

- 冷板设计:采用独立液冷板,为每个 GPU 芯片配备专用冷板,散热效率更高但复杂性增加。

- 快速接头:采用新型 NVUQD03 接头,尺寸缩小至前代的 1/3,单位成本降至 40-50 美元,但总数量翻倍(每个计算托盘需 14 对接头)。

- 系统总成本:单个 GB300 机架液冷系统成本约 38 万美元,占机架总成本的 42%,但通过优化设计和材料,总体拥有成本较 GB200 降低 20%。

3. 成本驱动因素

- 材料与工艺:高纯度铜、液态金属(如镓基合金)等材料成本较高,微通道冷板的精密制造工艺也增加了成本。

- 组件数量:GB300 因采用分布式冷板设计,快速接头数量大幅增加,导致相关成本上升。

- 系统复杂性:液冷系统的集成度和可靠性要求高,CDU、歧管等组件的复杂性也推高了成本。

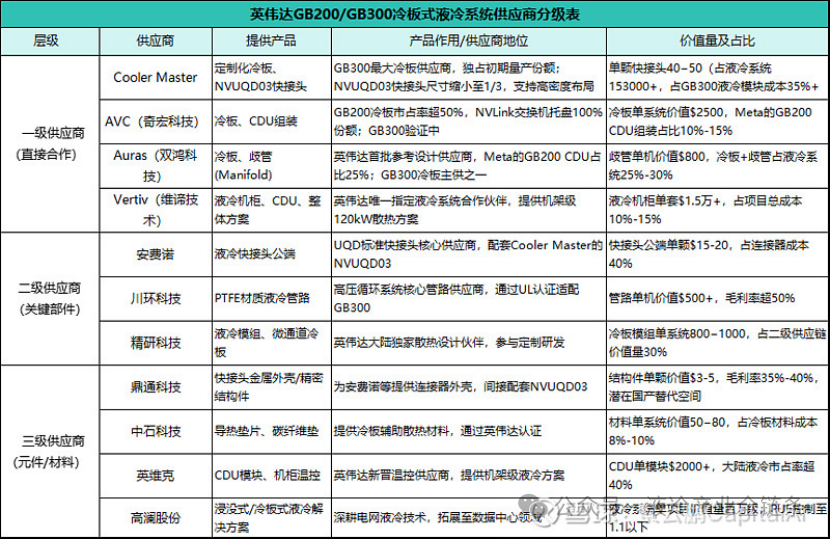

二、英伟达GB200/GB300冷板式液冷供应商拆解

1、英伟达GB系列供应链生态全景

- 一级供应商(直接合作):Cooler Master(冷板+快接头)、AVC(冷板/CDU组装)、Auras(歧管系统)、Vertiv(液冷机柜)主导核心技术,掌握液冷系统 35%+ 价值量(单模块成本占比最高达 35%-40%);

- 二级供应商(关键部件):安费诺(快接头公端)、川环科技(PTFE管路)、精研科技(定制冷板)提供关键部件;

- 三级供应商(元件/材料):鼎通科技(连接器外壳)、中石科技(导热材料)、英维克(CDU模块)贡献基础元件。

总结

GB200 和 GB300 的液冷系统成本高度集中在冷板、CDU、UQD 等核心组件,这反映了 AI 算力爆发对散热效率的极致追求。GB300 通过优化设计和材料,在提升性能的同时旨在降低总体拥有成本。随着 计算功率 需求的持续增长,高效的液冷技术已从可选项变为必选项,其供应链的成熟与成本优化将直接影响下一代 云原生 AI 基础设施的部署规模与效率。关于更多前沿技术讨论与资源,欢迎访问 云栈社区 进行交流。 |