翻一份300页的财报找数据,你会怎么做?先看目录,定位到相关章节,再细读具体内容。但现在大多数RAG系统不是这么干的——它们把文档切成碎片,然后靠向量相似度"撞大运"。

传统RAG的三个硬伤

我们先说说传统RAG(检索增强生成)是怎么工作的:把文档切块,转成向量,存进数据库,查询时算相似度。听起来挺科学,但实际用下来问题不少:

上下文被切碎了

固定窗口分块直接把完整段落拦腰砍断,一个完整的论述被拆得七零八落。

相似≠相关

语义上相似的内容,业务上可能八竿子打不着。检索结果里经常混进一堆看似相关、实则无用的片段。

不会推理

遇到需要跨章节综合分析的问题,向量检索就抓瞎了。

举个实际例子:你问"Q4净利润同比增长率",向量检索会把所有提到"净利润"的地方都翻出来,但你真正需要的是财务报表那一页,加上脚注里的计算口径说明——这需要推理,不是匹配。

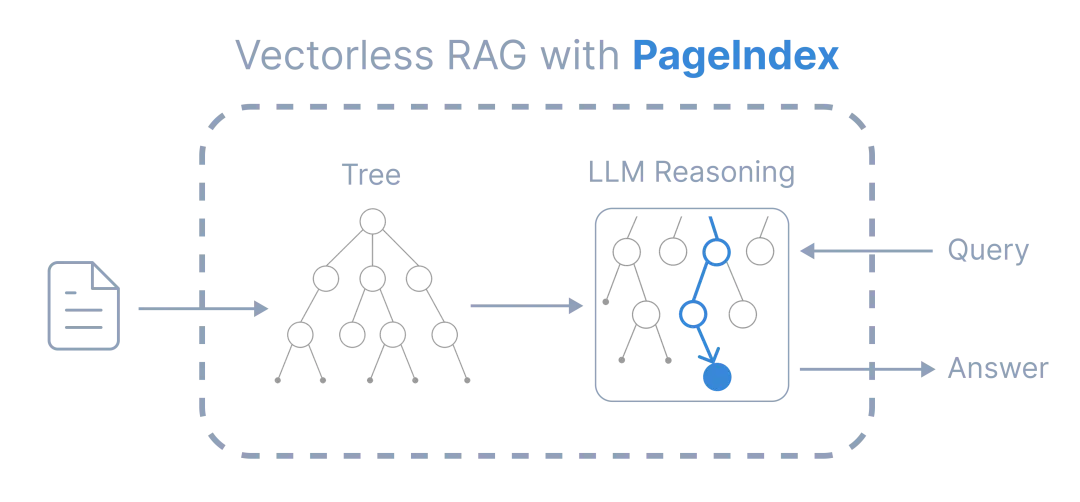

PageIndex怎么解决这个问题

PageIndex是VectifyAI开源的一个RAG框架,核心思路很直接:让LLM像人一样读文档。

工作流程就两步

第一步:把文档变成目录树

把PDF解析成层次化的树状结构,每个节点记录章节标题、页码范围,还有LLM自动生成的内容摘要。子章节递归嵌套,就像一本书的详细目录。

{

"title": "财务状况分析",

"node_id": "0006",

"start_index": 21,

"end_index": 28,

"summary": "本章节分析了公司2023年资产负债表变化...",

"nodes": [

{

"title": "流动资产构成",

"node_id": "0007",

"start_index": 22,

"end_index": 24,

"summary": "现金及等价物增长15%,应收账款周转率..."

}

]

}

第二步:在树上做推理检索

用户提问的时候,LLM在这棵树上执行多步推理:先判断问题属于哪个主题域,然后评估各个节点的相关性,逐层往下找最可能的分支,最后把相关上下文聚合起来生成答案。

整个过程可追溯、可解释,返回结果会告诉你具体在第几页、哪个章节。

三个关键特点

不用向量数据库

直接用LLM的推理能力做检索,不搞embedding和向量相似度那一套。

不做分块

保留文档原本的章节结构,不机械切分。上下文完整,关键信息不会被割裂。

模拟人的阅读习惯

浏览目录→定位章节→深入细节,每一步都有明确的推理依据。

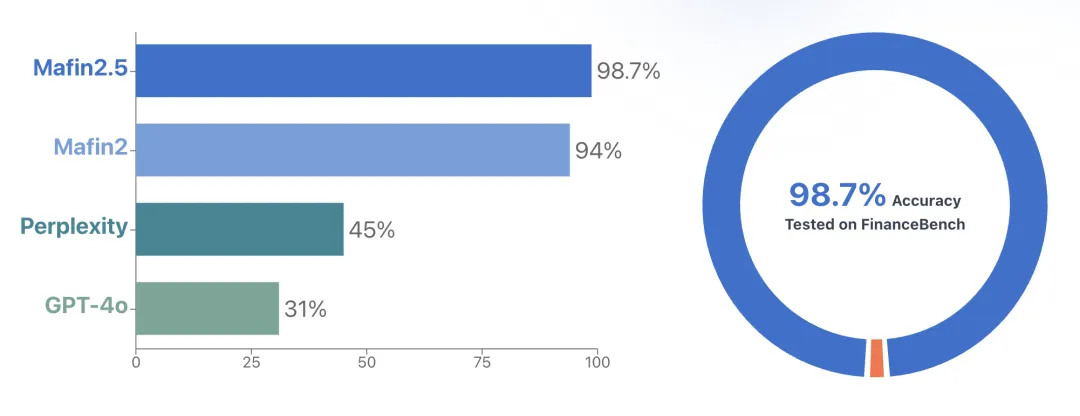

实测数据:FinanceBench 98.7%准确率

基于PageIndex搭建的Mafin 2.5系统,在金融文档问答测试FinanceBench上跑出了98.7%的准确率,明显超过传统向量RAG。

它能精确定位年报里的多层级财务指标,正确理解监管披露文件里的条件逻辑,还能跨章节追踪风险因素的演变路径。

这说明一件事:处理长文档、专业领域、需要推理的场景,推理能力比相似度匹配管用。

上手很简单

本地跑起来只要5分钟

# 克隆项目

git clone https://github.com/VectifyAI/PageIndex

cd PageIndex

# 装依赖

pip install -r requirements.txt

# 配个API密钥(OpenAI、Claude都行)

echo "CHATGPT_API_KEY=your_key" > .env

# 处理文档

python run_pageindex.py --pdf_path document.pdf

生成的树结构会存成JSON,可以直接拿来做检索或者二次开发。

云服务也有三种接入方式

Chat平台:网页版界面,上传PDF就能多轮问答

API调用:

from pageindex_sdk import PageIndexClient

client = PageIndexClient(api_key="your_key")

upload_result = client.upload_document("report.pdf")

response = client.chat_completions(

messages=[{"role": "user", "content": "总结风险因素"}],

doc_id=upload_result["doc_id"]

)

MCP协议:在Cursor、Claude Desktop这些AI IDE里直接调用,不用切换工具。

适合哪些场景

金融行业:年报、招股书、监管披露文件,提取财务指标、追踪风险因素

法律行业:合同、判例、法规文件,定位条款依据、分析逻辑链条

学术研究:论文、教材、技术手册,快速检索方法论、理解复杂概念

企业内部:知识库、技术文档,搭建可解释的智能问答系统

技术栈和扩展能力

核心依赖:LLM推理引擎(OpenAI / Claude / 国产大模型都支持)、轻量级JSON存储(不需要向量数据库)、结构保持型OCR(可选,处理复杂排版)

进阶功能:多文档对比分析、Vision RAG模式(直接处理PDF图像,跳过OCR)、流式输出

如果你在做后端架构或者研究智能数据处理方案,PageIndex提供了一个不错的思路。云栈社区的人工智能板块里也有不少开发者在分享基于PageIndex的实践案例。

开源和商业化

开源版本:MIT协议,GitHub上有完整代码

免费额度:200页文档处理

企业方案:私有化部署、VPC内网、SLA保障

最后说两句

PageIndex的价值不只是技术层面的创新,更重要的是思路的转变——从"匹配"到"理解",从"检索"到"推理"。它证明了一件事:给AI推理能力,它就能像人类专家一样工作。

这可能就是RAG的下一个方向:不是更快的向量搜索,而是更智能的推理导航。

📦 项目地址:github.com/VectifyAI/PageIndex

📖 官方文档:docs.pageindex.ai

🌐 学 Python:https://yunpan.plus/f/26

🌐 Ai 课程:https://yunpan.plus/f/29

关注《异或Lambda》,持续追踪AI生产力革命前沿

标签:#PageIndex #GitHub #RAG #文档智能 #推理检索 #开源项目 #LLM推理 #Python