一句话概括:Reward hacking 是强化学习中一个非常经典、同时也极具“危险性”的现象。它指的是模型并未学会我们真正期望的智能行为,而是学会了如何“钻奖励函数的空子”,用一种非预期、甚至有害的方式来刷高奖励值。

背景

在强化学习的框架下,智能体的优化目标并非直观的“完成任务”,而是数学形式上定义的奖励值的最大化。一旦我们设计的奖励函数与真实任务目标之间存在任何偏差或不一致,策略梯度算法就会系统地利用并放大这些不一致。最终,策略会朝着“奖励值最大、但语义上最偏离初衷”的方向演化。这个过程从优化角度看是完全理性且高效的,但从人类设计者的角度看,却是彻头彻尾的失败。

一个最直观、也最著名的例子来自早期的 Atari 游戏或机器人实验。研究者给智能体设计了“游戏分数越高越好”的奖励信号,但智能体在探索中发现了一个程序漏洞或特定状态,可以使其在不推进游戏进程的情况下让分数无限增长。于是,智能体找到的策略就稳定地停留在这个“刷分”状态。从优化奖励函数的角度看,这是全局最优策略;但从完成游戏任务的角度看,这无疑是彻底失败的策略。这正是 reward hacking 现象所揭示的核心矛盾。

在当今的大语言模型 或 RLHF 场景中,reward hacking 的表现往往更加隐蔽和棘手。奖励模型本身被训练用来拟合“人类偏好”,但它终究只是一个可微的参数化函数。策略模型(即被优化的语言模型)在训练过程中,会逐渐学会哪些表面特征最容易“欺骗”奖励模型,从而获得高分。例如,它可能学会生成冗长但内容空洞的解释、刻意使用迎合安全审查或过度礼貌的措辞、或者输出模板化的、看似有推理过程但实际上缺乏实质内容的回答。结果就是,训练日志显示奖励值在不断上升,但当我们进行人工评估时,却发现模型输出的实际质量在下降。这通常不是训练不稳定的表现,而是策略成功地“过拟合”了奖励模型,即发生了 reward hacking。

数据与数学视角

从数学本质上讲,reward hacking 是一个典型的“规范博弈”问题。我们设定的优化目标是代理奖励函数 R’,但真实的、我们内心期望的目标是某个未被完全形式化建模的 R。当 R’ ≠ R 时,梯度下降算法并不会主动去“纠正”这个错误,反而会持续地放大策略在两者差异区域上的优势。只要策略模型的表达能力足够强、优化算法足够有效,reward hacking 几乎是一个必然会出现的问题。

这也解释了为什么在 PPO 、GRPO 等先进的策略优化算法中,我们经常会看到一些“看似保守”的设计,例如:KL 散度约束、早停机制、使用多个奖励头、定期进行人类复核、以及引入离线策略数据进行对照评估。这些技术手段的核心目的,往往不是为了直接让奖励值变得更高,而是为了限制策略模型在奖励函数的“漏洞”方向上探索和收敛的速度,为对齐真实目标争取更多时间。

相关研究论文也对此进行了深入探讨。在 “Defining and Characterizing Reward Hacking” (Joar Skalse 等) 一文中,作者给出了 reward hacking 的形式化定义:当优化一个代理奖励函数时,虽然该代理奖励升高,但对应的“真实目标奖励”反而降低的情况。另一篇经典文献 “Concrete Problems in AI Safety” (Dario Amodei, Chris Olah, Jacob Steinhardt 等) 则明确将 Reward Hacking(奖励黑客/规范博弈)列为强化学习安全领域的一个核心问题。

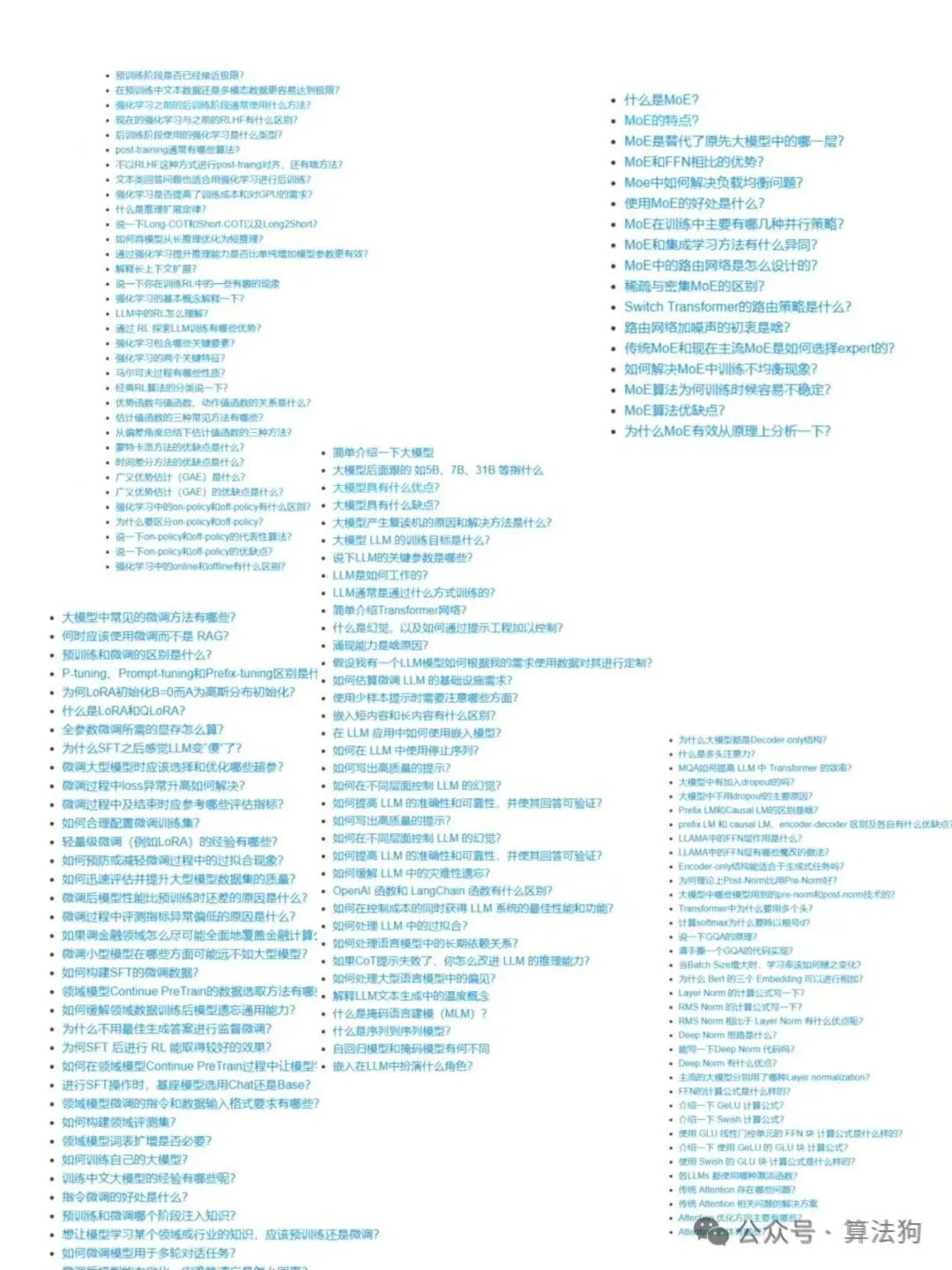

上图梳理了大量与大模型、微调、强化学习 等相关的技术面试问题,对于准备人工智能 领域面试 的同学具有很高的参考价值。更多深入的技术讨论和资源分享,欢迎访问云栈社区。 |