到了2026年,许多手机的相机参数已经飙升至2亿像素。回想十几年前,市面上主流手机还是800万像素,随后一路攀升至千万级、五千万,再到一亿像素,如今更是迈入了两亿像素的时代。

然而,把目光转向专业相机领域,情况却截然不同。如今许多价格上万元的微单相机,其有效像素可能仍停留在2400万左右,超过4000万像素的机型就已经可以被称为“高像素”相机了。

为什么参数上看似碾压的手机,实际成像的清晰度与细节,却常常无法与像素低得多的专业相机相媲美呢?高像素真的就等于高画质吗?问题的核心,很大程度上藏在了图像传感器的底层结构中。

手机高像素的局限:参数背后的真相

从理论上看,更高的像素理应带来更高的分辨率,让照片在放大后能呈现更多细节。但现实往往与理论背道而驰。许多手机在开启高像素模式后拍出的照片,并未带来预期的细节提升,放大后反而会呈现一种纹理模糊、细节失真的“塑料感”。

左:低像素模式放大 右:高像素模式放大

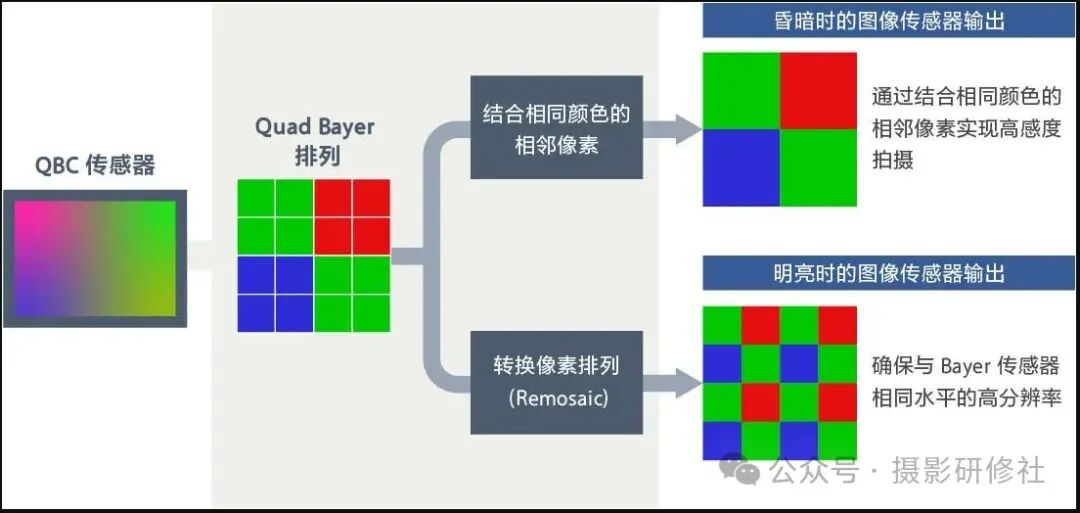

这种反差感的根源,在于现代手机传感器普遍采用的 Quad Bayer Coding 像素排列方式,它与传统相机传感器所采用的 拜耳阵列 在工作原理上存在根本差异。

拜耳阵列与色彩还原:相机传感器的基石

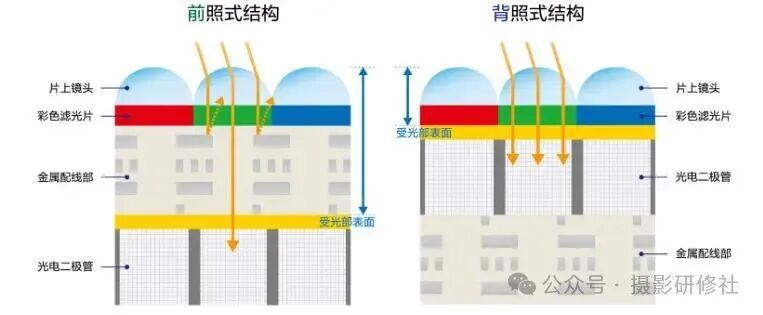

在光学色彩中,任何颜色都可以由红 (R)、绿 (G)、蓝 (B) 三原色按不同比例混合得到。图像传感器本身是“色盲”的,只能感知光的强弱。为了分辨颜色,传感器上方会覆盖一层彩色滤光片 (Color Filter Array, CFA)。

一块红色滤光片只允许红光通过,其下方的像素就能准确记录红色的亮度信息。那么,这个像素点对应的绿色和蓝色信息从何而来?答案是:通过相邻像素的绿色和蓝色信息进行插值运算“猜”出来的。这个过程被称为“去马赛克” (Demosaicing)。

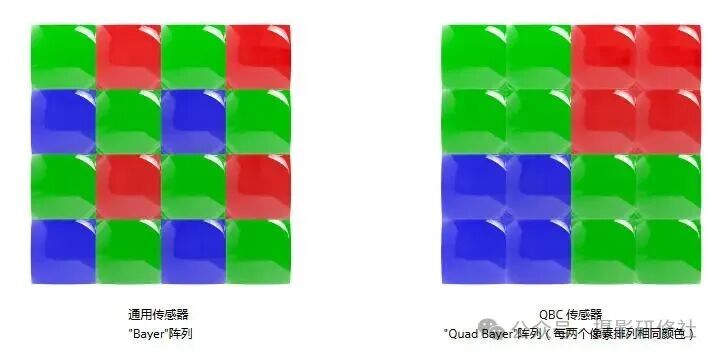

为了让“猜色”更准确,传统相机传感器广泛采用 拜耳阵列。这是一种经典的 RGGB 排列模式,滤光片按照“绿-红”和“蓝-绿”逐行交替,绿色像素数量是红色或蓝色的两倍,这符合人眼对绿色更敏感的特性。

QBC阵列:手机高像素的“代价”

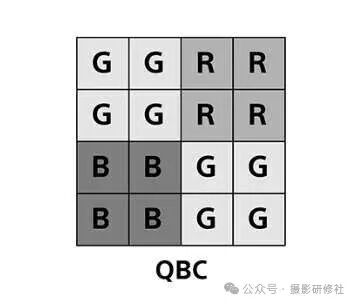

如今,绝大多数手机为了兼顾高像素和暗光表现,普遍采用了 QBC 像素排列。在这种排列下,原本 RGGB 的 2x2 单元被同色滤光片取代,例如四个相邻像素全是绿色、全是红色或全是蓝色。

QBC 排列最大的优势在于可以轻松实现“像素合并”。例如,一个标称 4800 万像素的传感器,通过将相邻 4 个同色像素合并为 1 个大像素,就能输出一张 1200 万像素的照片。合并后,“单个像素”的感光面积相当于增大了 4 倍,显著提升了暗光下的进光量和信噪比。因此,手机默认通常输出合并后的低像素照片以保证画质。

然而,当你开启“高像素模式”时,问题就暴露了。此时传感器试图输出全分辨率图像,但每个 2x2 的同色像素块内,像素的原始色彩信息是缺失的(因为滤光片颜色相同),需要依赖更远的异色像素来进行色彩插值。这极大地增加了“猜色”的难度和误差,导致色彩还原不准、细节纹理出现伪色和模糊,解析力反而不如传统的拜耳阵列传感器。

一个不太恰当的比喻是:与其说是 4800 万像素合并成了 1200 万像素,不如说它本质上是 1200 万个感光单元,通过特殊的滤光片排列“分割”出了 4800 万个像素数据点。

目前主流的方案有 QBC 4合1(最高像素约5000万)和 QQBC 16合1(最高像素约2亿)。

技术演进:硬件级Remosaic与AI增强

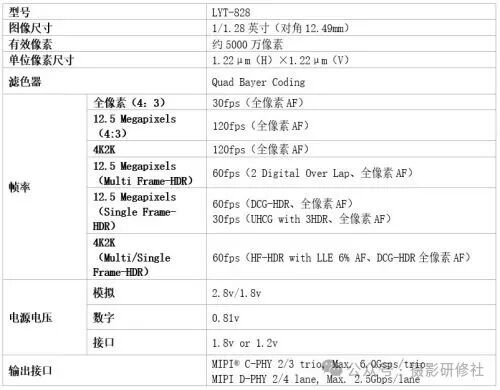

为了弥补 QBC 阵列在高像素模式下的解析力损失,传感器厂商也在不断推进技术进步。例如,索尼提出并实现了“片上 Remosaic”技术。

传统的 QBC 转拜耳(即排列重排)依赖手机 SoC 的软件算法进行,耗时耗能。索尼的解决方案是将专用的排列转换处理电路集成到图像传感器芯片内部。通过硬件直接进行拜耳图像再生成,实现了低功耗和实时处理,让视频拍摄也能享受高像素模式的细节。

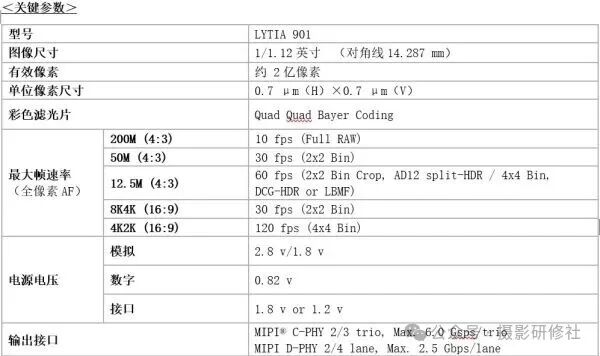

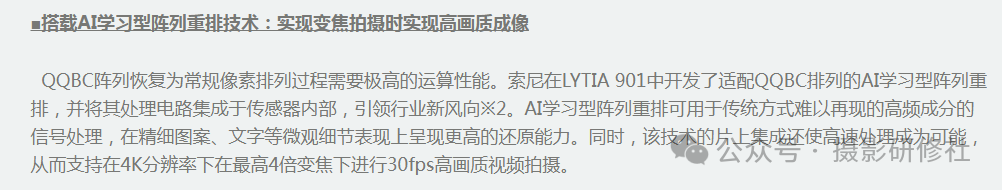

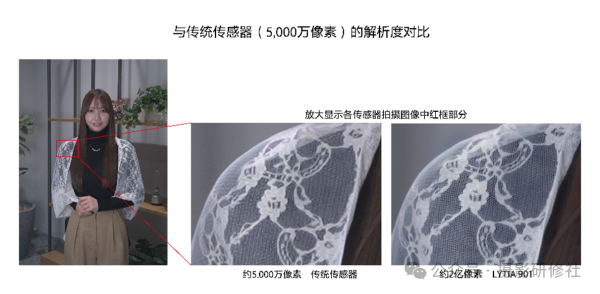

更进一步,索尼在 LYTIA 901 等传感器中集成了“AI 学习型阵列重排”技术。该技术利用 AI 模型来处理传统方式难以复原的高频信号,在呈现精细纹理、文字等微观细节时,具备更强的还原能力。片上集成也使得高速处理成为可能,从而支持在 4K 分辨率下进行高画质的变焦视频拍摄。

官方对比图显示,新技术确实显著提升了细节解析力。

微透镜(OCL)的影响:光线混合的代价

除了滤光片排列,片上镜头 (On-Chip Lens, OCL,也称微透镜) 的设计也影响着最终画质。OCL 位于每个像素上方,负责将光线汇聚到感光区域。

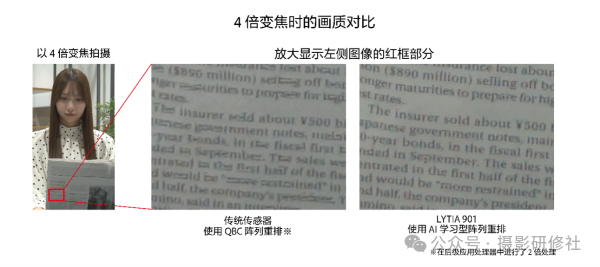

左:传统拜耳阵列(1像素对1OCL)

中:QBC阵列(1像素对1OCL)

右:QBC阵列(4像素共享1个OCL)

在一些采用 QBC 阵列的传感器中,为了简化工艺或优化性能,会采用“2×2 OCL”设计,即 4 个像素共享 1 个微透镜。这种设计的解析力天然不如“1像素1OCL”的方案。

因为人眼对亮度的感知远比对颜色敏感(黑白照片没有色彩但依然可以很清晰),所以亮度信息极大影响了图像的整体清晰度。4个像素共享一个微透镜,相当于把原本独立的4条光线先混合再分配,必然会产生轻度的光学模糊,这在追求极限细节时会成为瓶颈。

结语

所以,手机动辄上亿的像素参数,更多是营销和硬件竞赛下的数字游戏。真正的“有效像素”或“感知像素”,受到传感器尺寸、滤光片阵列、微透镜设计、处理器算法等多重因素的制约。

只有能切实提升画面细节和质感的高像素,才具有实际意义。如果只是纸面参数飙升,而最终成像的细节、色彩还原度没有相应提升,甚至因为底层结构的限制而有所牺牲,那么这样的“高像素”对于追求画质的用户而言,价值就非常有限了。理解这些底层的计算机成像原理,能帮助我们更理性地看待参数,在云栈社区与更多开发者交流时,也能更深入地探讨技术本质而非表面数字。