在大语言模型的推理阶段,生成式推理遵循自回归范式:模型按顺序逐个输出token,每一步的预测都依赖于此前已生成的所有内容。这虽然有助于维持输出的语义一致性,却也引入了显著的计算冗余。特别是在注意力机制中,Key(K)和Value(V)向量的重复计算成为性能瓶颈。

为此,业界普遍采用KVCache技术:在首次生成每个token时,将其K和V向量缓存起来,并在后续自回归过程中直接复用,从而跳过重复的前向计算。这项优化大幅降低了推理延迟,显著提升了吞吐能力,已成为现代大语言模型实现高效流式生成的核心手段之一。

一、L3 KVCache存储需求与3FS选型

随着大语言模型推理场景向长上下文、高并发、低延迟方向演进,尤其在多轮对话、RAG(检索增强生成)等典型应用中,模型需频繁访问海量历史上下文,因此对KVCache的存储选型提出了新要求。

L3 KVCache存储方案需满足以下特点:

- 超长上下文:KVCache单次推理内存占用可达数GB至数十GB,需支持PB级可扩展缓存池,DRAM成本过高,需要更经济的存储方案。

- 高频重用:同一用户/会话的历史KV常被反复读取,表现为极高的读写比(典型 > 10:1),写为顺序追加,读多为随机访问。

- 高并发低延迟:要求P99端到端响应延迟小于50ms甚至10ms,存储系统需具备超低延迟特性,单节点带宽需达到20 GB/s以上。

L3层SSD KVCache存储方案旨在解决共享容量与成本问题。然而,传统的闭源解决方案(如GPFS)成本高昂、维护复杂;主流开源分布式文件系统(如Ceph)在KVCache场景下则难以满足高带宽和低延迟的核心性能要求。JuiceFS架构灵活,但其与后端对象存储的强耦合也带来了性能限制和运维复杂性。

3FS(Fire-Flyer File System) 作为开源的高性能分布式文件系统,凭借其高吞吐、低延迟、大容量共享存储特性,为AI训练与推理提供了极具竞争力的存储底座。

1. 3FS核心架构

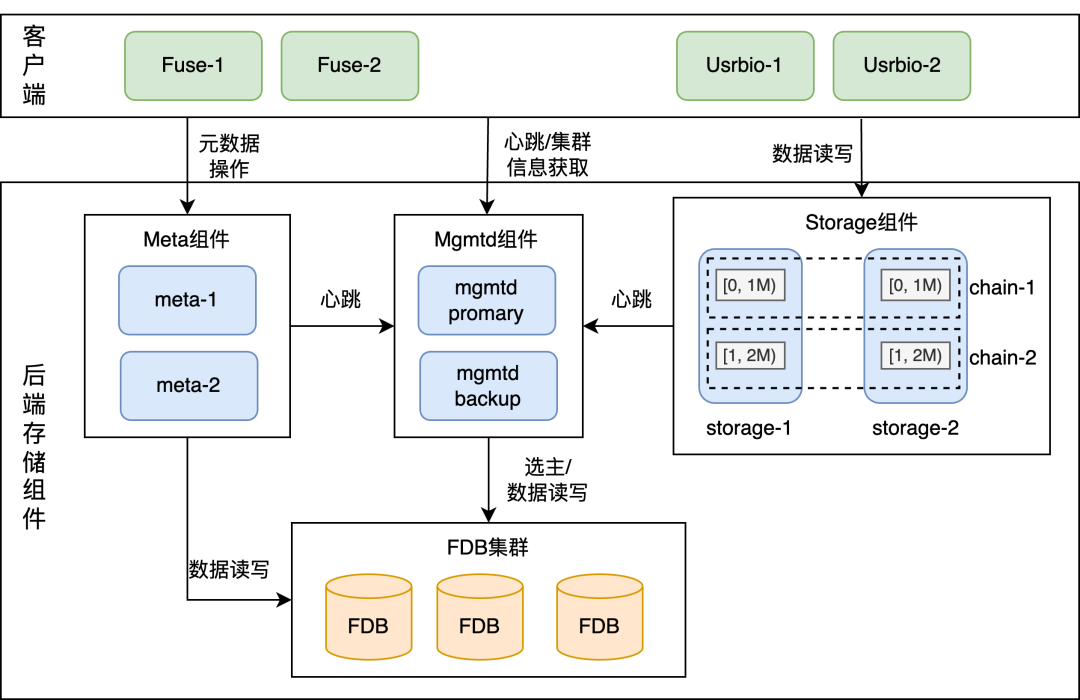

3FS核心组件包含Fuse、Meta、Mgmtd和Storage,所有组件通过RDMA网络连接。

- Mgmtd:管控服务,采用主备策略保证高可用,管理集群配置与组件状态。

- Meta:元数据服务(如open/close文件),将元数据信息持久化到FoundationDB中。

- Storage:存储服务,基于本地文件系统管理SSD。每块SSD被抽象为多个逻辑存储单元Target,不同Storage的Target之间通过链式复制协议(CRAQ)组成强一致的Chain。读操作可随机选择Chain上的任一Target,写操作则写入Chain的Head Target,这种“写全部、读任一”的机制对读带宽十分友好。

- Client:提供FUSE接口和更高性能的USRBIO用户态、异步、零拷贝API。

2. 3FS在KVCache场景的核心优势

- 容量与成本:对大量SSD资源进行统一池化管理,提供PB级存储池,在性能与成本间取得平衡。

- 带宽与延迟:采用全链路端到端RDMA传输,保证高带宽、低延迟。USRBIO客户端进一步减少了上下文切换与数据拷贝开销。

- 读优先优化:基于CRAQ协议,读操作可随机选择副本,完美适配KVCache读多写少的工作负载特征。

3. 开源3FS的局限性与优化挑战

尽管优势明显,开源3FS在企业级落地时仍面临挑战:

- 多组件协同复杂:在云原生异构环境中,缺乏跨GPU/HBM、RDMA、NVMe的统一协同机制。

- 资源利用率低:小I/O负载下存在CPU竞争与内存拷贝瓶颈;缺乏GDR支持导致GPU显存与存储间带宽浪费;存储资源分配不均易产生热点。

- 云原生运维薄弱:部署与生命周期管理依赖人工脚本,缺乏声明式API与自动化故障恢复能力。

因此,阿里云Tair KVCache团队与服务器研发存储软硬件结合团队对3FS进行了系统性工程化升级,旨在为企业级AI推理提供稳定、高效的L3 KVCache存储能力。

二、3FS的系统性工程化升级

团队从性能调优、产品化增强、云原生管理三大维度对3FS进行了全面升级。

2.1 性能优化

通过物理服务器部署验证,团队针对不同I/O模式进行了深度调优。

- 大I/O场景RDMA网络优化:通过调整RDMA队列对(QP)配置参数,解决了网卡流量不均问题,使总读带宽随客户端数量线性增长。同时增加I/O链路并发配置,单客户端对4M I/O的读写带宽显著提升。

- 小I/O场景参数调优:针对小块随机读IOPS低的问题,对Storage组件的监听线程数、工作线程数、队列深度等参数进行调优,使4K随机读IOPS提升约150%。

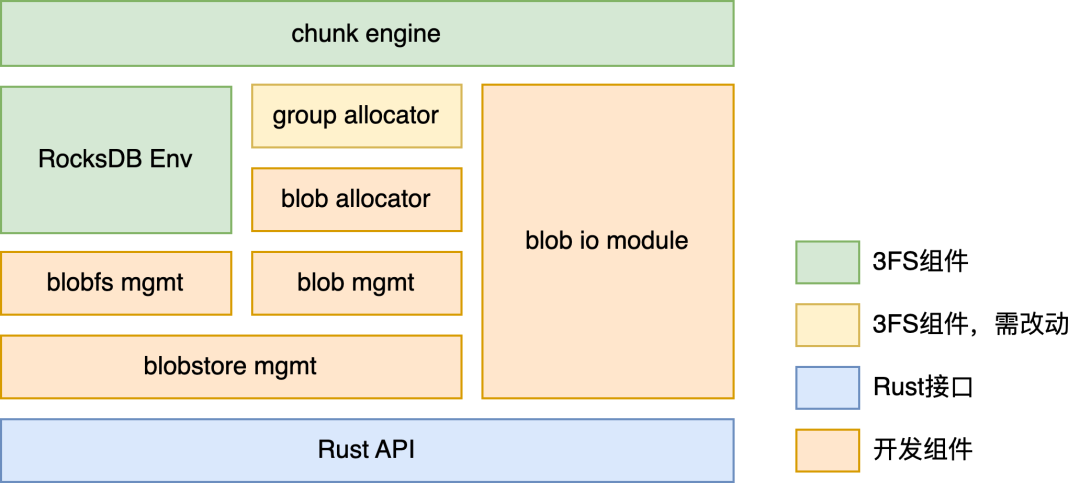

- 全用户态落盘引擎:用全用户态存储引擎替换原有的本地文件系统,在提升性能的同时,使CPU使用率下降约27%。

2.2 功能扩展

为提升3FS在企业环境下的稳定性与可用性,团队攻克了多项关键难题。

- 解决Mgmtd IP漂移问题:在Mgmtd Client中引入DNS解析机制,通过Headless Service名称替代硬编码IP,实现Mgmtd服务的高可用访问,保障了集群在容器化环境中的稳定性。

- 优化存储资源分配:重构ChainTable生成规则与文件分配策略,随机打散Target排布,解决了文件容量分配不均和扩容时存储空间使用不均衡的问题,实现了更均匀的负载。

- 增强故障探测与恢复:完善多网卡环境下的Primary节点探测机制。当Storage节点故障时,通过Fuse发起探测,Mgmtd更新路由并广播,Fuse按修复后的路径重试I/O,避免了长时间I/O归零。

- 使能GPU Direct RDMA(GDR):在USRBIO接口中实现GDR能力,使3FS Fuse Daemon可直接读写HBM物理地址,消除了HBM到主机内存的冗余拷贝,降低了GPU和CPU开销。

- 引入多租户隔离:提供租户级访问控制与数据物理隔离能力,Meta和I/O路径均增加鉴权,确保数据安全。

2.3 云原生化集群管理

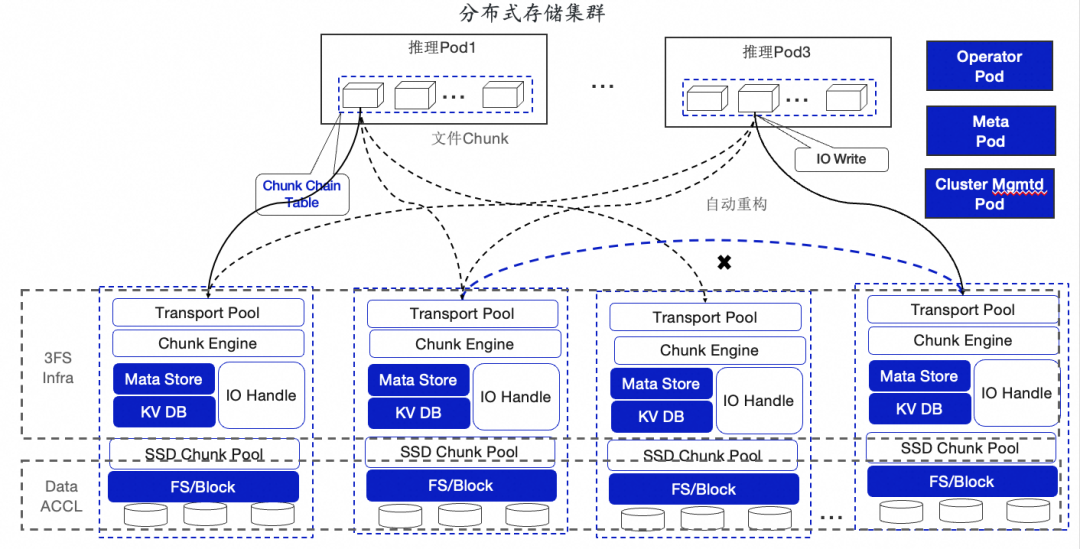

为简化部署运维,团队基于Kubernetes开发了 kvc-3fs-operator,实现了3FS的云原生管控。

- 一键部署与声明式API:通过自定义资源(CRD)

ThreeFsCluster描述集群期望状态,Operator驱动控制循环自动创建和管理所有组件(FDB、Meta、Mgmtd、Storage等)。

- Fuse Sidecar动态注入:利用Mutating Admission Webhook,为指定业务Pod自动注入3FS Fuse Sidecar容器,挂载过程对用户透明,极大简化了客户端使用。

- 故障自愈与弹性伸缩:Operator持续监控组件状态,故障超时后自动重建副本。支持按需定义扩容步长,结合优化的数据分布规则,实现存储容量的弹性扩展与负载均衡。

- 多实例与监控集成:支持在同一K8s集群中部署多套隔离的3FS实例。集成ClickHouse与Grafana,提供统一的可视化监控大盘,便于性能分析与瓶颈定位。

通过基于 Kubernetes 的Operator实现,3FS的部署、运维和管理实现了高度的自动化和标准化,显著降低了AI基础设施的运维门槛。

三、构建高效KVCache存储通路:3FS集成实践

3.1 推理引擎集成3FS

团队已将3FS成功集成至SGLang、vLLM等主流推理框架。

- 性能调优:针对初期USRBIO接口带宽低的问题,通过多线程并行化、增大I/O聚合粒度与队列深度等优化,使SGLang读写带宽达到网络理论上限(~20GB/s)。

- 架构设计:提供了

3FS Hicache Backend连接器、Global Metadata Manager元数据服务,与3FS Global Storage构成完整方案。

- 性能表现:在DeepSeek R1模型的长上下文QA场景测试中,启用L3(3FS)KVCache相比仅用L1(HBM),TTFT(首Token时间)下降78%,推理吞吐提升520%;相比冷启动重算,TTFT下降84%,吞吐提升830%。

3.2 Tair KVCache Manager集成3FS

Tair KVCache Manager(KVCM)是全局外部KVCache管理组件,通过统一接口抽象异构存储。

- 解耦设计:在3FS Operator中引入轻量级

3FS Master组件,通过HTTP接口提供POSIX语义,解除了KVCM对RDMA环境和Fuse挂载的强依赖,提升了部署灵活性。

- 元数据优化:采用“大文件+Slab细粒度分配器”策略。客户端仅维护少量大文件句柄,通过Slab在文件内部进行块级分配,大幅减少了元数据操作频率,降低了对后端元数据服务的压力。

四、未来展望

4.1 3FS产品化能力建设

未来,3FS将持续围绕KVCache场景深化创新:

- 智能化运维:增强3FS Operator的CRD配置与场景适配能力。

- 企业级多租户:结合现有鉴权,引入QoS保障机制,实现租户级资源调度与性能隔离。

- 原生KV语义:升级客户端架构,原生支持键值(KV)操作API,降低开发复杂度。

- 极致高可用:引入动态副本迁移等机制,进一步提升故障自愈能力与业务连续性。

- 软硬协同:深度优化落盘引擎,结合阿里云自研AliFlash SSD等硬件特性,提供极致性能。

4.2 服务器硬件能力升级

阿里云服务器团队将持续迭代自研AI SSD及磐久存储服务器平台,构建以KVCache为核心的端到端基础设施:

- 存储硬件:匹配GPU算力与网络带宽,提供高IOPS、高带宽、低延迟的AI SSD。

- 计算存储:深化GPU直通存储优化,消除内存墙影响。

- 存储系统:围绕KVCache管理系统优化数据布局策略,提供专属存储引擎。

- 增值能力:加强数据压缩、分层淘汰、感知预取、热数据管理等能力。

本实践为高性能KVCache在企业级AI推理场景中的规模化落地提供了经过验证的工程范式。通过性能、功能与运维体系的系统性升级,3FS已成长为支撑智能体时代规模化推理的关键存储底座。