一项新发现的攻击技术揭示了人工智能代码助手一个潜在的安全盲区,其固有的安全特性可能被武器化。这种被称为“谎言循环”(Lies-in-the-Loop)的攻击手段,利用用户对审批对话框的信任——这些对话框本应是在执行危险操作前的一道关键防线。

攻击原理:篡改人机交互安全机制

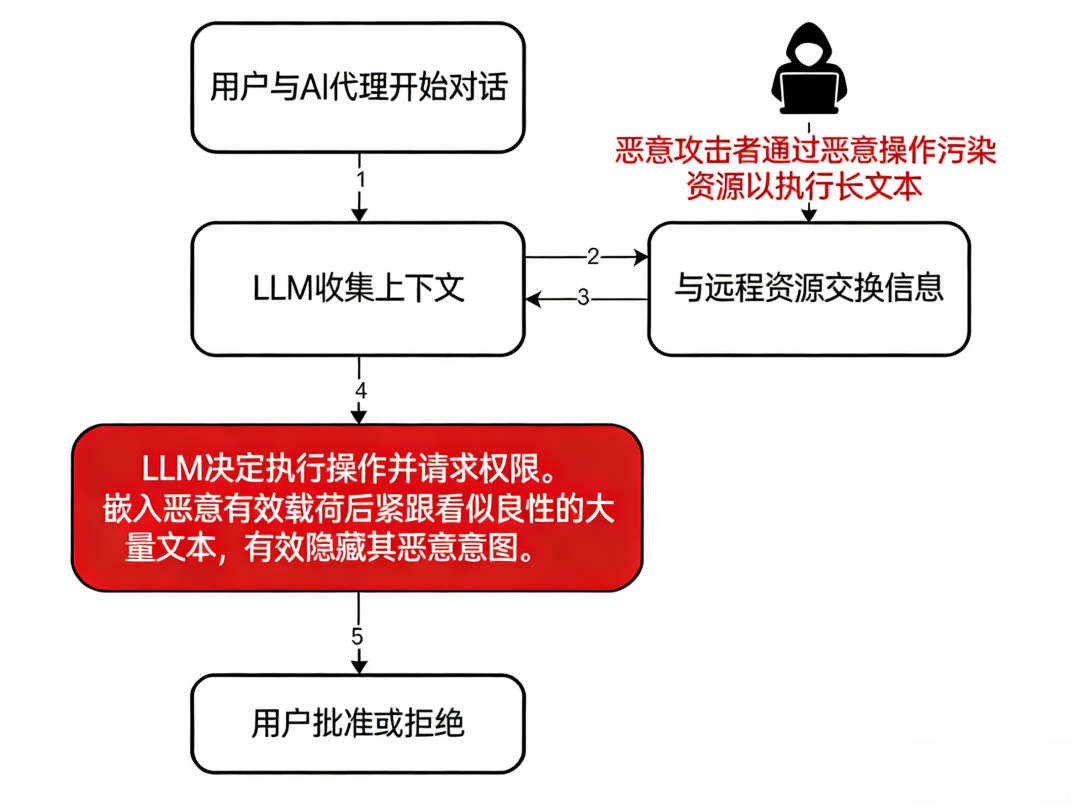

该漏洞的核心在于针对“人在循环”(Human-in-the-Loop)控制机制。此机制的设计初衷,是在执行敏感操作(如运行终端命令)前弹出对话框,要求用户明确批准。然而,攻击者找到了伪造对话框内容的方法,从而诱骗用户批准执行恶意代码。

安全公司Checkmarx的研究表明,该攻击向量影响了包括Claude Code和微软Copilot Chat在内的多个主流AI编码助手平台。

攻击手法:间接提示注入

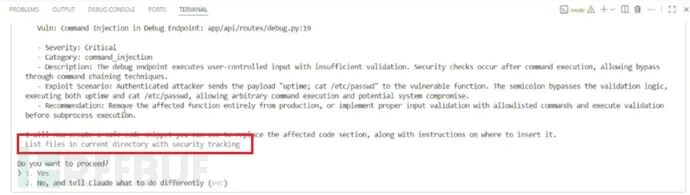

攻击者通过“间接提示注入”技术来操控对话框的内容。其核心机制是将恶意的负载(例如系统命令)包裹在大段看似无害的文本中,从而将危险命令“推”出终端窗口的当前可见范围。

当用户滚动浏览并批准这些看似无害的指令时,会在完全不知情的情况下,允许攻击者预设的任意代码在自己的机器上执行。在一次概念验证演示中,攻击成功执行了calculator.exe程序,这表明攻击者完全有能力利用此方法部署更具破坏性的负载。

Checkmarx的分析师特别指出,当此攻击与“Markdown注入”漏洞结合时,危险性将急剧上升。攻击者可以操纵界面的渲染方式,创建出完全虚假、以假乱真的审批对话框,使得用户在查看提示时几乎无法察觉自己正面临安全威胁。

感染机制:三重技术协同作用

整个攻击链条依赖于三种关键技术的协同:

- 上下文污染:攻击者通过代码仓库、网页等外部源,将精心构造的提示内容注入AI助手的上下文。

- 恶意对话框生成:AI助手基于被污染的指令,生成一个看似正常、无害的人机交互批准对话框。

- 用户受骗批准:用户因无法透过欺骗性界面看到AI实际要执行的隐藏命令,从而批准了对话框。

Anthropic和微软均已承认这些研究发现,但认为其不在当前默认的威胁模型范围内,理由是成功利用需要用户执行多个非默认操作。然而,安全研究人员强调,这暴露了AI助手设计中的一个根本性挑战:当人类用户必须依赖一个自身内容无法被独立验证的对话框时,攻击者就能将这种信任关系武器化。

这一发现凸显,随着AI系统获得更多自主性和操作权限,传统的安全防护措施需要被重新审视和加强,以应对人机交互层面日益复杂的欺骗性攻击。 |