在 PPO(近端策略优化)算法中,pg_clipfrac(Policy Gradient Clipping Fraction)是一个用于事后监控的重要统计量。理解它对于调整训练过程至关重要。

在训练过程中的每一个时间步 t,PPO 会首先计算一个重要性采样比率 r_t(θ):

r_t(θ) = \frac{\pi_\theta(a_t|s_t)}{\pi_{\theta_{old}}(a_t|s_t)}

随后,PPO 的裁剪目标函数(clipped objective)会将这个比率限制在 [1 - ε, 1 + ε] 的区间内,其中 ε 是一个超参数(通常为0.1或0.2)。但这里需要明确一个关键点:clip ratio (pg_clipfrac) 本身并不是这个裁剪后的值。

那么,它究竟统计的是什么呢?根据论文,pg_clipfrac 统计的是:

在一批样本中,有多少比例的样本,其原始的 r_t(θ) 没有超出裁剪区间 [1-ε, 1+ε]。

也就是说,在一个批次(batch / rollout)的样本上,pg_clipfrac 通常计算为:

pg\_clipfrac = \frac{count( r_t(θ) \in [1-ε, 1+ε] )}{N}

其中 N 是总样本数。更精确的实现中,可能会按 token、时间步或样本进行统计,但其本质完全相同。在代码里,它通常通过计算未超出裁剪范围的比率数量,除以总样本数得到。

这个值是我们监控 PPO 算法稳定性的一个核心指标。如果你想了解更多关于 强化学习 中此类算法的细节,可以深入探索相关专题。

- 如果

pg_clipfrac 值过高(例如持续接近1):这意味着几乎所有的 r_t(θ) 都落在了裁剪区间内。这通常表明新旧策略差异很小,更新步长(由学习率等因素影响)可能过小,导致训练效率低下,学习缓慢。

- 如果

pg_clipfrac 值过低(例如持续接近0):这意味着大量的 r_t(θ) 都超出了裁剪区间,被强制裁剪到了 1±ε。这通常表明新旧策略差异过大,当前的学习率或更新步长可能太大了,存在策略崩溃的风险。此时应该降低学习率,让策略更新更平缓。

因此,在实践当中,我们期望 pg_clipfrac 保持在一个中等水平(例如0.2左右),这表明策略在进行有意义的更新,同时又被裁剪机制有效地约束着,保证了训练的稳定性。理解这些指标是准备 面试求职 中算法相关岗位的关键一环。

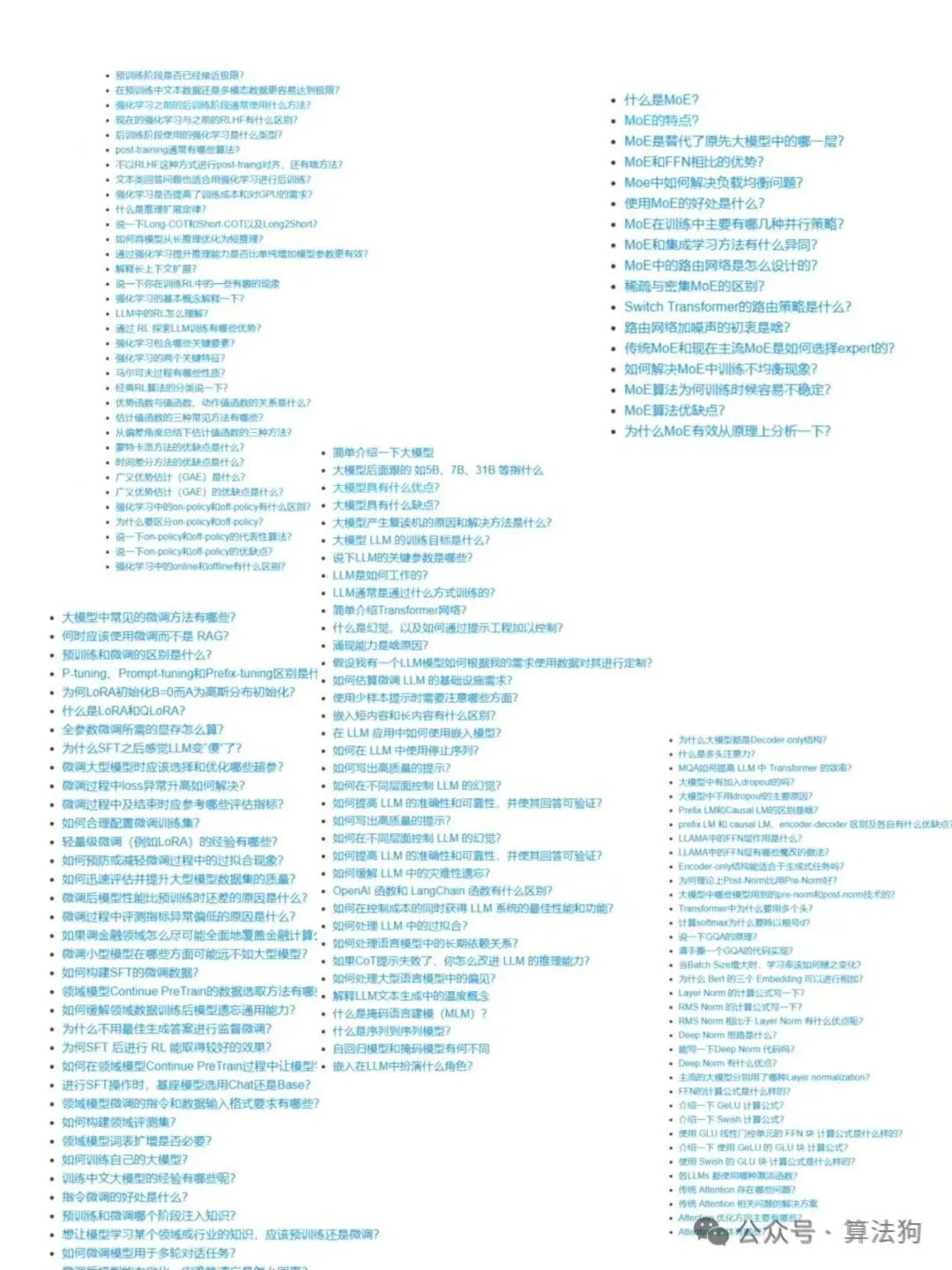

为了更直观地展示相关技术概念的范围,可以参考下图,其中涉及了包括 RLHF 在内的多种机器学习与深度学习话题:

总而言之,pg_clipfrac 不是一个直接用于优化目标的组成部分,而是一个至关重要的诊断工具。它就像汽车仪表盘上的警示灯,帮助我们判断 PPO 这个“引擎”是否在既高效又安全的工况下运行。通过监控它,我们可以及时调整超参数(主要是学习率),确保训练过程平稳、高效地收敛。更多关于算法优化与工程实践的讨论,欢迎在 云栈社区 与开发者们交流。 |