背景

现在大家使用大模型,基本都是依赖各大厂商提供的在线服务。但你想过没有,万一在一个完全没有网络的环境下,你又恰好遇到需要AI协助的问题,该怎么办呢?别着急,今天就介绍一个可以在手机上离线部署、并能通过本地网络访问的大模型解决方案:MNN-LLM。

官方下载地址和文档如下:

https://gitee.com/alibaba/MNN

简介

MNN是一个轻量级的深度神经网络引擎,全面支持深度学习模型的推理与训练。它的设计目标就是跨平台,能够在服务器、个人电脑、手机以及各类嵌入式设备上高效运行(包括iOS和Android系统)。目前,MNN已经在阿里巴巴集团内部的手机淘宝、手机天猫、优酷等超过30个App中广泛应用,覆盖了直播、短视频、搜索推荐、商品图像搜索、互动营销、安全风控等多个核心场景。

而MNN-LLM正是基于强大的MNN引擎,专为运行大语言模型(Large Language Model, LLM)而开发的解决方案。它致力于解决大语言模型在个人设备上的高效部署难题,无论是手机、电脑还是嵌入式设备。它兼容市面上主流的模型,例如通义千问、百川、智谱ChatGLM以及LLaMA系列等。

手机部署和API开放教程

想在手机上体验离线大模型?跟着下面几个步骤操作即可:

- 安装App:从上面的下载地址中找到并下载

MNN Chat 应用,在Android设备上完成安装。

- 下载模型:打开App,进入“模型市场”。这里提供了多个不同规格的模型,请根据自己手机的硬件性能(特别是内存大小)选择合适的模型下载。切记不要勉强运行参数过大的模型,否则可能导致手机卡顿甚至发热严重。

- 开始对话:模型下载完成后,在“我的模型”列表中可以看到它。点击模型即可进入聊天对话界面。

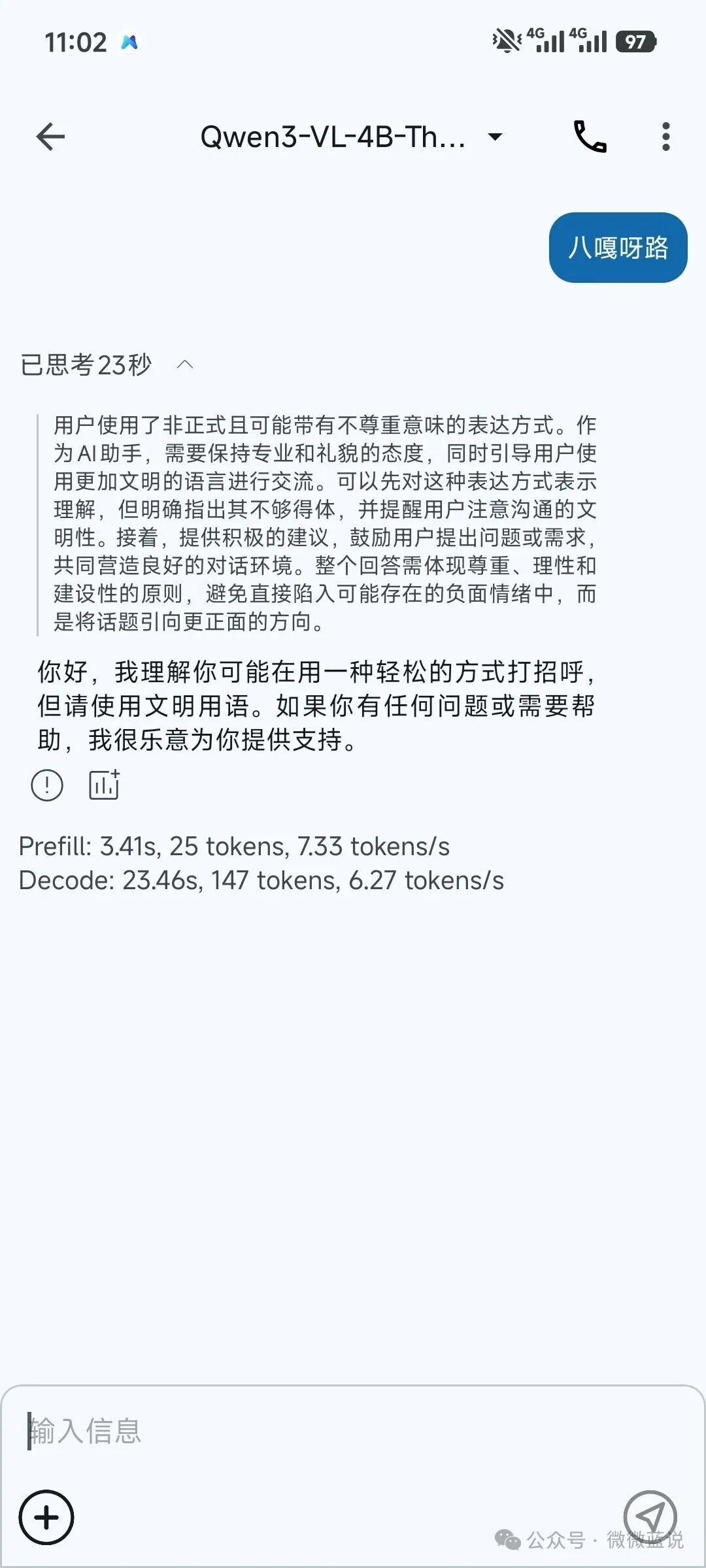

- 离线测试:现在,你可以尝试关闭手机的Wi-Fi和移动数据,然后向模型发送一个问题。如图所示,即使完全断网,模型依然能够进行独立的思考和回复,真正做到不依赖互联网。

- 启用API服务:如果你希望通过电脑网页来与手机上的模型对话,可以在App的“设置”中,找到并开启“开启API网络服务”选项。这将启动一个兼容OpenAI API格式的本地服务器。

- 配置网络:开启API服务后,通常还需要进入“API服务设置”界面,确认服务器监听的端口(默认是

8080)和IP地址(手机在局域网内的IP,如172.167.3.39)。保持默认设置或按需调整即可。

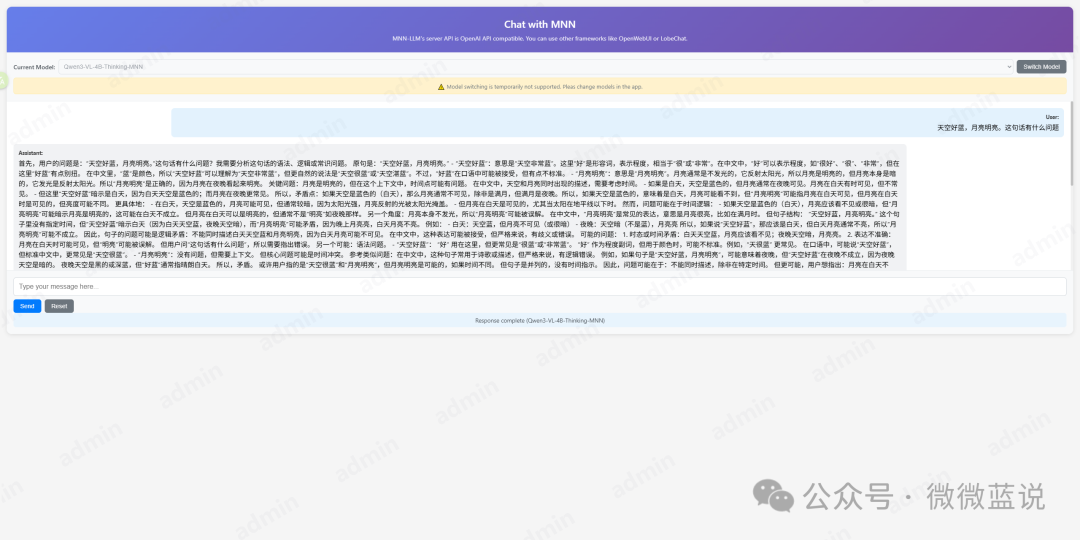

- 网页访问:确保你的电脑和手机连接在同一个Wi-Fi网络下。然后在电脑的浏览器中,输入上一步中配置的访问地址(例如

http://172.167.3.39:8080),就能打开一个Web对话界面进行聊天了。根据实测,这个Web界面的功能相对基础,但用于基础的对话测试完全足够。

注意:最好保持手机常亮或解除手机的电池睡眠限制,会影响大模型的运行速度

为了保证模型推理过程稳定流畅,建议在长时间使用API服务时,将手机设置为常亮模式,或者在系统电池优化设置中,对此App禁用休眠限制。否则,手机屏幕熄灭进入省电模式后,可能会严重影响模型的响应速度。

拓展

MNN-LLM方案不仅限于直接使用预训练模型聊天,它还为你打开了更多可能性:

- 模型微调:你可以基于自己的数据集,对模型进行进一步的训练和微调,让它更贴合你的专属需求。

- 应用集成:将本地部署的大语言模型作为后端服务,你可以开发出各种充满创意的离线AI应用,比如个人知识库助手、离线翻译工具等,只有想不到,没有做不到。

对于热爱折腾的开发者来说,这无疑是一个极具吸引力的“新玩具”。如果你也对移动端AI和边缘计算感兴趣,欢迎来云栈社区一起交流更多实战心得和开源项目。 |